Nếu là một dân công nghệ thực thụ, bạn sẽ chẳng thể nào không biết đến khái niệm Hadoop là gì phải không nào? Trong bài viết ngày hôm nay topviecit.vn cùng đi tìm hiểu chi tiết về HDFS nhé!

Hadoop là gì?

Hadoop là gì? Hadoop được hiểu là một dạng framework, mà cụ thể đó chính là Apache. Mã nguồn mở này cho phép ứng dụng phân tán nhằm mục đích lưu trữ và quản lý những dữ liệu lớn.

Hadoop ở dạng mô hình MapReduce, đây là mô hình chia nhỏ ứng dụng ra thành nhiều phân đoạn khác nhau được chạy song song trên nhiều node khác nhau.

Dù được viết bằng Java nhưng Hadoop vẫn hỗ trợ C++, Python, Perl qua cơ chế streaming.

>>>Xem thêm: Data Science Là Gì? Kỹ Năng Của Một Data Scientist Giỏi

Mục đích sử dụng của Hadoop là gì?

- Mục đích sử dụng của Hadoop là gì? Nó được dùng trong mục đích làm việc và giải quyết khối lượng dữ liệu khổng lồ tính bằng Petabyte.

- Xử lý dữ liệu lớn được lưu trữ ở nhiều phần cứng khác nhau, mục đích yêu cầu xử lý đồng bộ hoặc dùng xử lý trong môi trường phân tán.

- Giải quyết một số lỗi xuất hiện thường xuyên.

- Dùng để bằng thông giữa các phần cứng vật lý lưu trữ các dữ liệu phân tán có giới hạn.

Tìm hiểu về HDFS

Chắc hẳn bạn đã từng nghe rất nhiều về khái niệm HDFS nếu làm việc trong ngành IT hoặc liên quan đến ngành. Thế nhưng bạn hiểu được bao nhiêu về HDFS. Nếu bạn cũng đang gà mờ trong khái niệm này vậy thì cùng chúng mình đi tìm hiểu chi tiết về HDFS nhé!

HDFS là gì?

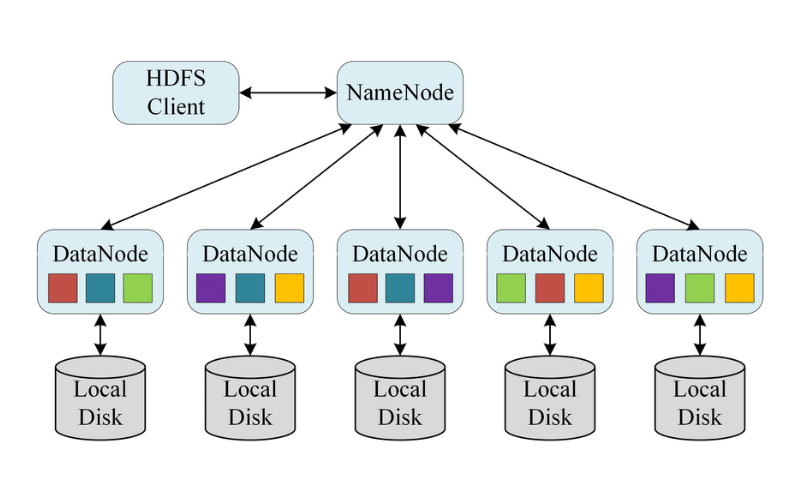

HDFS hay còn gọi là Hadoop Distributed File System. Đây là một hệ thống lưu trữ dữ liệu được sử dụng bởi Hadoop. Với chức năng là cung cấp khả năng truy cập với hiệu suất cao đến toàn bộ dữ liệu nằm trên các cụm của Hadoop.

HDFS ra đời với mục đích phân chia dữ liệu ra các ổ cứng trên nhiều máy tính trong trường hợp dữ liệu lớn dần và kích thước của file dữ liệu vượt ra ngoài phạm vị lưu trữ.

HDFS thường được dùng trên những loại phần cứng với chi phí vừa phải, lý do là vì các máy chủ rất hay xảy ra trường hợp bị lỗi phần cứng. HDFS được lập trình cho mục đích chịu lỗi cao, từ đây giúp giảm thiểu đi quá trình phát sinh lỗi.

HDFS sẽ sinh ra các mảnh nhỏ hơn của dữ liệu lớn rồi mới bắt đầu thực hiện phân tán chúng lên các nodes khác nhau. Và miếng dữ liệu nhỏ hơn được sao chép trên nhiều nodes khác.

Chính vì thế, ngay khi node bất kỳ chứa dữ liệu có hiện tượng bị lỗi thì ngay lập tức hệ thống sẽ tự động sẽ tự động sử dụng dữ liệu từ 1 node khác để bắt đầu xử lý.

Đây là một tính năng làm nên sự khác biệt của HDFS.

>>>Xem thêm: Ngôn ngữ lập trình Big Data. Những kỹ năng cần có của big data developer

Ưu điểm nổi bật của HDFS

Có thể nói ở thời điểm hiện tại HDFS là một trong những hệ thống được các lập trình viên sử dụng thường xuyên và rộng rãi. Đó là nhờ những ưu điểm tuyệt vời mà nó đem lại:

- Nhờ HDFS mà dữ liệu có thể phân tán. Cụ thể, một cụm Hadoop gồm có 20 máy tính, khi bạn đưa một file dữ liệu vào HDFS. Ngay lập tức, file đó sẽ tự động được chia nhỏ thành nhiều phần và lưu trong 20 máy tính đó.

- HDFS có thể tính toán và phân tán song song thay vì chỉ dùng một máy để xử lý công việc như bình thường. Với HDFS, các máy sẽ hoạt động song song và xử lý chung một công việc giúp tiết kiệm thời gian một cách đáng kể.

- HDFS có thể nhân bản file. Nhờ ưu điểm này mà chúng ta sao lưu toàn bộ dữ liệu khi không may một máy tính trong cụm Hadoop bị phát sinh sự cố mất file.

- HDFS hoàn toàn có thể mở rộng theo chiều dọc.

- HDFS còn có thể mở rộng hệ thống theo chiều ngang. Nhờ vậy mà người dùng không cần tốn tiền nâng cấp phần cứng mà chỉ cần sử dụng một chiếc máy tính khác là hoàn toàn có thể chia sẻ với máy tính hiện tại.

HDFS giúp giải quyết những vấn đề nào?

HDFS giúp giải quyết giải quyết 3 lỗi sau một cách triệt để:

- Lỗi phần cứng thường xuyên

Khi HDFS tích hợp với hệ thống giúp phát hiện và tự động khôi phục một số lỗi thường xuyên của phần cứng. Nhờ vậy bạn có thể giảm rủi ro xuống một mức thấp nhất có thể.

- Phân chia dữ liệu lớn thành tập dữ liệu có dung lượng nhỏ hơn

HDFS đóng vai trò phân chia những tập dữ liệu hàng trăm Terabyte thành những tập dữ liệu có dung lượng thấp hơn. Nhờ việc phân chia được diễn ra trên hệ thống máy tính mà các Developer có thể quản lý dễ hơn, từ đó giảm thiểu được thời gian truy xuất dữ liệu và đơn giản hóa quá trình quản lý.

- Dùng chuyên biệt cho các ứng dụng xử lý dạng khối

Bạn biết đấy toàn bộ các file khi được hình thành trên hệ thống HDFS đều có chung một đặc điểm là đều được ghi, đóng lại và không thể chỉnh sửa được, nhờ vậy mà tính bảo mật và nhất quán cho các tập tin của dữ liệu rất cao.

>>>Xem thêm: Json Là Gì? Những Điều Dân Lập Trình Cần Biết Về JSON

Trên đây là toàn bộ những kiến thức về HDFS và chắc hẳn đến đây bạn cũng đã biết được khái niệm Hadoop là gì rồi phải không nào? Đừng quên theo dõi chúng mình để biết thêm nhiều thông tin bổ ích và thú vị khác nhé!

Hình ảnh: Sưu tầm